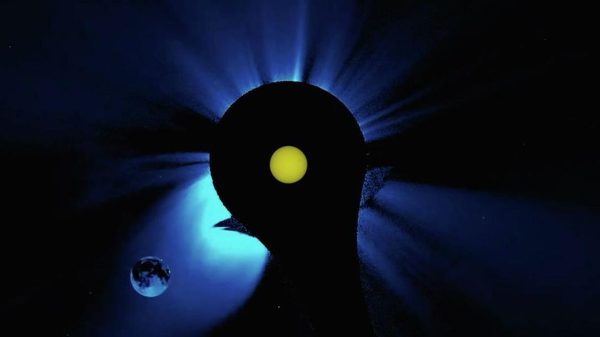

Наблюдение с помощью дронов может оказаться иллюзией

Поскольку искусственный интеллект становится все более мощным и используется в военных целях, ученые утверждают, что для правительств, технологических компаний и международных организаций жизненно важно обеспечить его безопасность. В большинстве соглашений по безопасности ИИ подчеркивается необходимость контроля человека над этой технологией.

Многие западные эксперты по безопасности выразили мнение, что люди могут служить защитой от неправильного использования и потенциальных ошибок искусственного интеллекта (ИИ). Это может включать, например, человеческий обзор контента, созданного ИИ. Однако растущий объем исследований и реальных примеров военного использования ИИ показывает, что идея о том, что люди могут эффективно контролировать компьютерные системы, сталкивается с определенными трудностями.

Несмотря на усилия по разработке правил для ИИ, многие из них уже содержат положения, которые поддерживают человеческий контроль и участие. Например, закон ЕС об ИИ требует, чтобы высокорисковые системы — такие как те, которые автоматически идентифицируют людей с помощью биометрических технологий, включая сканеры сетчатки глаза — были протестированы и проверены как минимум двумя квалифицированными лицами.

В военной сфере правительство Великобритании признало важность человеческого контроля в своем ответе на парламентский отчет об ИИ в системах вооружения в феврале 2024 года. В отчете отмечалась необходимость «осмысленного человеческого контроля», что означает, что персонал должен быть должным образом обучен. В настоящее время военные беспилотники контролируются операторами, которые отвечают за действия беспилотников. Однако внедрение ИИ может сделать беспилотники и используемые ими компьютерные системы более эффективными и автономными.

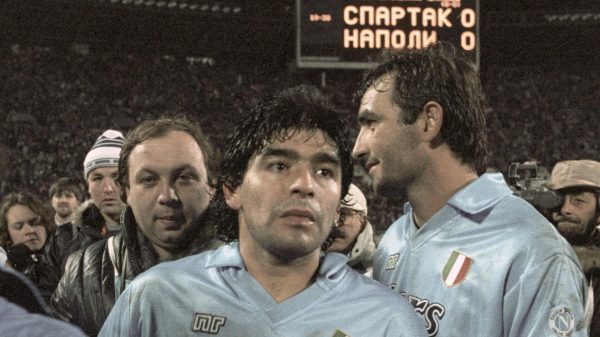

Израильско-палестинский конфликт продемонстрировал использование такой технологии. Сообщается, что Израиль использует систему на основе искусственного интеллекта, которая работает совместно с другими автоматизированными системами для отслеживания местоположения обнаруженных объектов. Ранее в 2017 году американские военные запустили проект под названием Maven, целью которого было внедрение искусственного интеллекта в системы вооружения.

Согласно рекомендациям академических исследований в области этики ИИ, проект должен включать специального сотрудника, который будет контролировать результаты работы механизмов поиска цели, что является важным элементом процесса принятия решений.

Американский психолог Мэри Каммингс отметила, что люди могут начать чрезмерно доверять машинным системам и их выводам — это явление называется ошибкой автоматизации.

«Такое доверие может повлиять на роль человека как контролера автоматизированного процесса принятия решений, поскольку операторы могут быть менее склонны подвергать сомнению выводы системы», — поясняет специалист.

В другом исследовании, опубликованном еще в 1992 году, исследователи Батья Фридман и Питер Кан утверждали, что люди могут ослабить свое чувство моральной ответственности при работе с компьютерными системами, вплоть до того, что они начинают считать себя не ответственными за последствия и даже приписывать автономность самим компьютерным системам.

Свежие комментарии