Но в работе искусственного интеллекта есть свои подводные камни

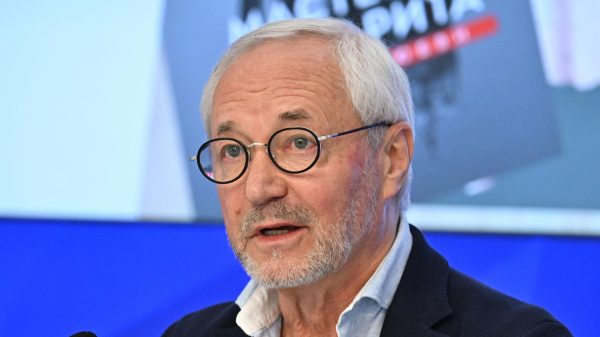

На Западе усомнились не только в эффективности искусственного интеллекта (ИИ) в борьбе с коррупцией, но и в этичности его использования. Помощник или противник искусственного интеллекта в борьбе со злоупотреблениями и взяточничеством, считает профессор Юрий Жданов, доктор юридических наук, заведующий кафедрой международного права Российского государственного социального университета, заслуженный юрист России.

Фото: ru.freepik.com

Фото: ru.freepik.com

— Они пришли к выводу, что ИИ не решит проблему коррупции сам по себе, независимо от того, насколько он эффективен в прогнозировании или раскрытии неправомерных действий или злоупотреблений.

— Исследования по этике и искусственному интеллекту проводились в Тринити-колледже в Дублине. Работы по этой теме публикуются с 2015 года в ведущих научных журналах, посвященных бизнесу. Были проанализированы аннотации из 58 отдельных отчетов. Оказалось, что доминирующей темой, освещенной в 13 статьях, было доверие. Анализ позволил нам выявить несколько ключевых противоречий при рассмотрении использования передовых технологий в сфере надлежащего управления и борьбы с коррупцией. Аналитики обозначили эти проблемы следующим образом: конфиденциальность против прозрачности, свобода слова против защиты человеческого достоинства, свобода выбора против необходимости обеспечения человеческой автономии.

— И я бы с ними согласился. С этической точки зрения технологии независимы. Но их могут использовать с одинаковой эффективностью и воздействием как силы добра, так и силы зла. Весь вопрос в том, кто контролирует эти технологии, кто программирует и ставит задачи ИИ.

Ведь как в идеале использовать ИИ для борьбы с коррупцией? Если очень схематично, то он анализирует всю доступную информацию о чиновниках, бизнесменах, крупных сделках, торгах, транзакциях, экономических преступлениях, в общем — абсолютно обо всем, включая посты в социальных сетях, личную переписку и конфиденциальные персональные данные — что сразу же вызывает вопросы о законности таких действий.

— Примерно такие же, как у ученых из Тринити-колледжа в Дублине. Например, в России, как и во многих других странах, подобные методы сбора личной, конфиденциальной информации требуют законодательного закрепления. Необходима правовая база — общее законодательство об искусственном интеллекте. В частности, «Цифровой кодекс», федеральный закон «О цифровом профиле», как минимум внесение соответствующих изменений в антикоррупционное законодательство. Необходимо решить вопросы, касающиеся субъективности системы ИИ, допустимости использования результатов ее деятельности в качестве доказательств, гарантий прав граждан, в отношении которых проводятся проверочные мероприятия с использованием ИИ.

— ИИ ищет расхождения. Расхождения могут быть, скажем, между декларацией о доходах чиновника и его фактическими расходами. Его имущество и бизнес могут быть оформлены на родственников или друзей. Изучаются сферы, в которых наиболее вероятны коррупционные риски, причем системные: государственные закупки, реализация доступа к любым ресурсам — арендным площадям, депозитам, распределение социальных льгот и т. д. Изучаются характерные признаки уклонения от уплаты налогов, схемы вывода средств на офшорные счета, отмывание денег. Кроме того, ИИ может защитить бизнес от незаконного уголовного преследования.

— Например, есть некий корпоративный конфликт между хозяйствующими субъектами. Но вместо разрешения в арбитражном споре одна из сторон возбуждает уголовное дело против другой стороны. Если есть «заказ», уголовное дело возбуждается очень быстро, зачастую потерпевших нет, проводится быстрая доследственная проверка и сразу предлагается мера пресечения в виде заключения под стражу, происходит фальсификация или сокрытие доказательств.

Конечно, все это можно обнаружить обычным способом, что называется, вручную. Но ИИ сделает это в 20 раз быстрее. В этом случае он даст только наводку, а в каждом конкретном случае живые специалисты будут детально разбираться.

Примером инструмента, который уже разработан и доказал свою эффективность, является Ravn — программное обеспечение на базе искусственного интеллекта, которое может быстро и точно фильтровать, индексировать и обобщать документы, превосходя по эффективности людей. Оно получило известность благодаря своей роли в раскрытии дела о коррупции в Rolls-Royce в 2008 году, когда оно помогло британскому Управлению по борьбе с мошенничеством (SFO) проанализировать 30 миллионов документов, ежедневно обрабатывая 600 000 документов.

А в США уже много лет эксплуатируется несколько таких систем. В целом, Америка очень хорошо собирает информацию о своих госслужащих. Кстати, в России также запущена аналогичная антикоррупционная система под названием Poseidon, которая работает на основе искусственного интеллекта. Подобная программа уже действует в Росатоме и показала очень хорошие результаты. Для нас внедрение Poseidon очень актуально. Глава Следственного комитета (СК) России Александр Бастрыкин подсчитал ущерб от коррупции в стране: в 2024 году он достиг 14,2 млрд рублей.

— Дело в том, что для борьбы с системной коррупцией машинному обучению нужен большой объем данных. Тогда результаты будут корректными, если только не будет — опять же, системного — сбоя. То есть собираемая информация должна быть объективной и честной. А для этого должна быть очень серьезная экспертная и ведомственная разработка ключевых показателей. Если это будет сделано недобросовестно, например, теми людьми, которым выгодно текущее положение дел, то смысла в такой системе не будет. Эти «эксперты» заложат в алгоритм показатели, которые никогда не выявят настоящих коррупционеров.

Кроме того, самообучающийся ИИ может ошибаться сам по себе и совершенно искренне, без всяких сомнений, лажать. Такая ошибка может возникнуть даже из-за адаптации системы к национальному языку — пресловутые трудности перевода.

— К сожалению, да. Например, скандал с детскими пособиями «Toeslagenaffaire» в Нидерландах, где ошибка в алгоритме привела к тому, что десятки тысяч уязвимых семей были несправедливо обвинены в мошенничестве, а сотни детей вообще были разлучены со своими семьями. Дело привело к краху правительства.

В Австралии в так называемой схеме «Robodebt» алгоритм сопоставления данных (также с ошибкой) неправильно рассчитал переплаты получателям пособий, в результате чего было подано 470 000 несправедливых уведомлений о долгах и 775 миллионов долларов неоправданного долга, заявленного получателями пособий, что вызвало национальный скандал, который расследовала Королевская комиссия. Вот как мы боремся с коррупцией и злоупотреблениями.

Но вот с какой проблемой столкнулись США: предвзятость выборки данных. Согласно исследованию американских экспертов, опубликованному в нескольких СМИ, включая The Guardian, «модели ИИ, предназначенные для присвоения рейтингов коррумпированности отдельным лицам, были снабжены данными о предыдущих судебных процессах. Эти данные отражали, среди прочего, случаи предвзятости, связанные с более высокими показателями неправомерных осуждений среди представителей расовых меньшинств. Таким образом, ИИ подтвердил дискриминацию, маргинализацию или исключение из правового поля больших слоев населения». Так что неолиберальное движение Black Lives Matter, как бы вы к нему ни относились, не родилось на пустом месте — ИИ сыграл в этом значительную роль.

Независимая комиссия по борьбе с коррупцией (ICAC) в австралийском штате Новый Южный Уэльс подготовила отчет, в котором изложены как возможности, так и угрозы, создаваемые ИИ. Потенциальные возможности включают «способность ИИ повышать интеллект путем фильтрации, сортировки и анализа больших наборов данных; распознавание образов; прогнозирование и моделирование; анализ настроений; обнаружение аномалий данных; и интеграцию и анализ данных из нескольких источников. ИИ также может иметь потенциал для сокращения возможностей для коррупции, ограничивая свободу действий человека при принятии решений».

Однако ICAC также отметила, что ИИ рискует подорвать ее усилия по борьбе с коррупцией: человек с достаточными техническими знаниями может исказить данные или манипулировать моделями обучения, чтобы изменить выходные данные системы.

— Оказывается, так оно и есть. Ведь ИИ пока лишен человеческой способности сомневаться и критически оценивать информацию. А если все наборы данных предвзяты, ИИ будет принимать предвзятые решения. Вот в чем ловушка — наша вера в объективные, непредвзятые данные. Увы, это далеко не всегда так. <стр>Аналитики приводят пример: «Несколько штатов США начали оценивать риск повторного совершения правонарушений заключенными на основе персональных и демографических данных, которые заставляют алгоритмы принимать решение о режиме, при котором правонарушитель может быть реабилитирован. Теоретически такой инструмент должен снизить предвзятость в решениях, принимаемых отдельными судьями, поскольку судьи, по-видимому, принимают разные решения в зависимости от времени суток или от того, голоден ли судья или устал. Система, управляемая ИИ, оказывается, основана на данных с аналогичным риском предвзятости и может фактически отправить людей в тюрьму, если статистика в конечном итоге даст обвиняемому высокий балл.”

Другой пример: статистическая информация о демографических данных населения, охватывающая образование, расу, доход и местоположение, может быть серьезно предвзятой при использовании в системах принятия решений на основе ИИ. Данные о мобильных телефонах из страны, где наличие мобильного телефона означает, что вы, скорее всего, городской, мужской и богатый человек, уже предвзяты. Набор данных, показывающий перемещения этих телефонов каждое утро, идеально подходит для использования при планировании общественного транспорта для более богатой половины населения в столице бедной страны. Но набор данных, вероятно, будет генерировать предвзятость, если используется для целей, которые включают сельское население, женщин или детей. Чтобы смягчить предвзятость и ошибки, алгоритмы необходимо тестировать в разных контекстах и отслеживать во время использования.»

— Болезненно. Например, голландский суд признал недействительной систему обнаружения мошенничества в сфере социального обеспечения, которая использовала персональные данные из нескольких источников. Официальной причиной было несоблюдение права на неприкосновенность частной жизни в соответствии с Европейской конвенцией о правах человека. Он отметил, что существует риск того, что система будет предвзятой по отношению к людям из малообеспеченных районов.

Китай также создал систему ИИ под названием Zero Trust для анализа больших наборов данных с целью оценки производительности и личных характеристик многочисленных государственных чиновников, включая информацию об их активах. Однако с 2019 года китайская система была прекращена во многих округах и городах, как сообщается, из-за опасений по поводу возможности ложных срабатываний и ненадежной эффективности в обнаружении конкретных коррупционных практик.

В связи с этим эксперты предупреждают: «Необходимо постоянно остерегаться возможной дискриминации и предвзятости при использовании ИИ в борьбе с коррупцией. Важно обеспечить, чтобы преимущества ИИ были сбалансированы с его потенциальными рисками, и чтобы его использование в борьбе с коррупцией основывалось на принципах справедливости, подотчетности и прозрачности».

— Увы, они все чаще задумываются о том, какого монстра они создали и к чему все это может привести. И, вы правы, эти мысли безрадостны и даже апокалиптичны.

Так, британо-канадский ученый-компьютерщик, профессор Джеффри Хинтон, которого часто называют «крестным отцом» искусственного интеллекта, считает, что ИИ уничтожит человечество даже не в течение ближайших трех десятилетий, как предсказывалось ранее, а раньше, предупреждая, что темпы изменений в технологиях «гораздо быстрее», чем ожидалось. Такое заявление он сделал в программе Today на радио BBC. По его словам, вероятность того, что ИИ приведет к вымиранию человечества в течение ближайших трех десятилетий, составляет «от 10 до 20 процентов». Ранее Хинтон заявлял, что существует 10-процентная вероятность того, что эта технология будет иметь катастрофические последствия для человечества.

— Профессор посетовал, что человечеству «никогда раньше не приходилось иметь дело с существами, более разумными, чем мы сами. По сравнению с мощными системами ИИ, люди будут как трехлетние дети рядом со взрослыми».

В прошлом году Хинтон попал в заголовки газет после того, как ушел с работы в Google, чтобы более открыто говорить о рисках неконтролируемого ИИ, сославшись на опасения, что «плохие люди» будут использовать эту технологию, чтобы навредить другим. Основная проблема кампании по безопасности ИИ заключается в том, что создание общего искусственного интеллекта или систем, которые умнее людей, может привести к тому, что технология создаст экзистенциальную угрозу, выйдя из-под контроля человека.

— Да, государственный контроль над технологиями: «Просто позволить крупным компаниям получать прибыль будет недостаточно, чтобы обеспечить их безопасную разработку. Единственное, что может заставить эти крупные компании проводить больше исследований в области безопасности, — это государственное регулирование».

Помните, Хинтон — один из трех разработчиков ИИ, получивших премию ACM AM Turing — эквивалент Нобелевской премии в области компьютерных наук — за свою работу. Однако один из них, Янн Лекун, главный специалист по ИИ в компании Марка Цукерберга Meta (компания признана экстремистской организацией, ее деятельность запрещена в РФ — «»), преуменьшил экзистенциальную угрозу и заявил, что ИИ «действительно может спасти человечество от вымирания».

Свежие комментарии