Эксперты говорят, что дело подчеркивает опасность автоматического обнаружения изображений сексуального насилия над детьми

Технологические компании, такие как Google, имеют доступ к огромное количество данных, но для них нет контекста, говорит технолог ACLU. Фотография: Авишек Дас/Sopa Images/Rex/Shutterstock

Технологические компании, такие как Google, имеют доступ к огромное количество данных, но для них нет контекста, говорит технолог ACLU. Фотография: Авишек Дас/Sopa Images/Rex/Shutterstock

Google отказалась восстановить учетную запись мужчины после того, как она ошибочно пометила сделанные им медицинские снимки паха своего сына как материал о сексуальном насилии над детьми (CSAM), впервые сообщила New York Times. Эксперты говорят, что попытка применить технологическое решение социальной проблемы неизбежно приведет к ловушке.

Эксперты давно предупреждают об ограничениях автоматизированных систем обнаружения изображений сексуального насилия над детьми, особенно в связи с тем, что компании сталкиваются с давлением со стороны регулирующих органов и общественности, требующих помочь в борьбе с существованием материалов о сексуальных домогательствах.

«Эти компании имеют доступ к чрезвычайно инвазивным объемам данных о жизни людей. И все же они не имеют представления о том, какова на самом деле жизнь людей», — сказал Дэниел Кан Гиллмор, старший технолог ACLU. «Существует множество вещей, в которых просто факт вашей жизни не так понятен для этих информационных гигантов». Он добавил, что использование этих систем технологическими компаниями, которые «действуют в качестве доверенных лиц» для правоохранительных органов, подвергает людей риску быть «захваченными» «властью государства».

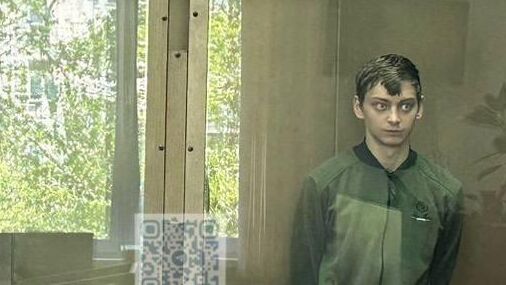

Мужчина, которого New York Times идентифицировала только как Марка, сфотографировал пах своего сына, чтобы отправить его врачу, после того как понял, что он воспален. Врач использовал это изображение, чтобы поставить диагноз сыну Марка и выписать антибиотики. Когда фотографии были автоматически загружены в облако, система Google идентифицировала их как CSAM. Двумя днями позже Gmail Марка и другие учетные записи Google, включая Google Fi, который предоставляет его телефонную услугу, были отключены из-за «вредоносного контента», который является «серьезным нарушением политики компании и может быть незаконным», сообщила Times со ссылкой на сообщение на его телефоне. Позже он узнал, что Google пометил другое видео, которое было у него на телефоне, и что полицейское управление Сан-Франциско возбудило в отношении него расследование.

С Марка сняли все обвинения, но Google заявил, что останется при своем решении.

«Мы следуем законодательству США в определении того, что представляет собой CSAM, и используем комбинацию технологии сопоставления хэшей и искусственного интеллекта, чтобы идентифицировать его и удалить с наших платформ», — сказала Криста Малдун, представитель Google.

Малдун добавил, что сотрудники Google, которые проверяют CSAM, были обучены медицинскими экспертами выявлять сыпь или другие проблемы. Сами они, однако, не были медицинскими экспертами, и с медицинскими экспертами не консультировались при рассмотрении каждого случая, сказала она.

Насколько конфиденциально ваше приложение для отслеживания месячных? Не очень, как показывает исследование. Подробнее

По словам Гиллмора, это лишь один из способов причинения вреда этими системами. Например, чтобы устранить любые ограничения, которые алгоритмы могут иметь при различении изображений сексуального насилия и медицинских изображений, компании часто привлекают человека. Но эти люди сами по себе ограничены в своем опыте, и для получения надлежащего контекста для каждого случая требуется дополнительный доступ к пользовательским данным. Гиллмор сказал, что это гораздо более навязчивый процесс, который все еще может быть неэффективным методом обнаружения CSAM.

«Эти системы могут создавать реальные проблемы для людей», — сказал он. «И дело не только в том, что я не думаю, что эти системы могут поймать каждый случай жестокого обращения с детьми, дело в том, что они имеют действительно ужасные последствия с точки зрения ложных срабатываний для людей. Жизнь людей может сильно измениться из-за машин, а люди, вовлеченные в процесс, просто принимают плохое решение, потому что у них нет причин пытаться это исправить».

Gillmor утверждал, что технология не является решением этой проблемы. На самом деле, по его словам, это может создать много новых проблем, в том числе создание надежной системы наблюдения, которая может нанести несоразмерный вред тем, кто находится на обочине.

«Есть мечта о своего рода техно-решения, [где люди говорят]: «О, ну, вы знаете, есть приложение для меня, чтобы найти дешевый обед, почему не может быть приложение для поиска решения сложной социальной проблемы, такой как детская сексуальная насилие?», — сказал он. «Ну, вы знаете, они могут быть не решены с помощью тех же технологий или набора навыков».

Свежие комментарии