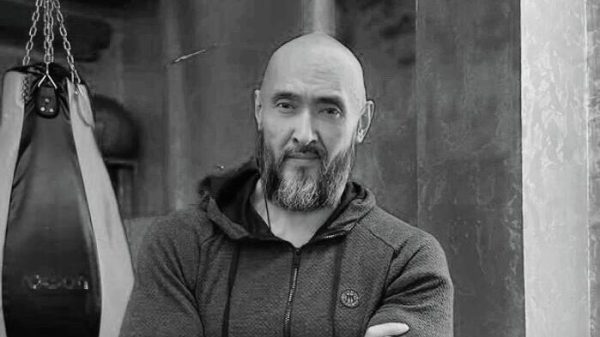

Zen< br />МОСКВА, 14 январяВ мире появляются люди, которые готовы работать моделями для мошеннических deepfake-атак — они предоставляют злоумышленникам свои изображения и голоса для использования в deepfake-атаках, рассказала менеджер по продуктовому портфелю VisionLabs Татьяна Дешкина.

«Молодые люди, зарабатывающие на финансовом мошенничестве, стали предоставлять свои данные — изображение лица и голос — для использования в deepfake-атаках. Первые такие объявления появились в Китае. В 2024 году молодая женщина разместила объявление о поиске работы deepfake-моделью. В своем профиле она указала большой опыт участия в схемах инвестиционного мошенничества», — рассказала Дешкина.

Модели Deepfake обычно предоставляют свои данные для создания виртуальных персонажей в фильмах, рекламе и видеоиграх. Однако мошенники используют эти данные для обмана пользователей, а наиболее распространенной атакой Deepfake является использование технологии синхронизации губ, когда движения губ на видео изменяются так, чтобы соответствовать другому тексту, создавая иллюзию реальной речи.

Эксперт также рассказал о случаях сговора с мошенниками — люди добровольно отказываются от изображений лиц и документов, а злоумышленники получают доступ к застрахованным счетам и крадут у них деньги. Часть «добычи» достается тому, кто предоставил свои данные.

«Кроме того, преступники часто «мигрируют» из одного района в другой. Например, с помощью системы распознавания лиц были пресечены многочисленные попытки финансового мошенничества со стороны лиц, ранее пойманных на краже в магазинах», — добавила Дешкина.

Свежие комментарии