В информационном бюллетене этой недели: Dall-E 2 может вызвать в воображении яркие изображения собак в беретах или космонавтов, играющих в баскетбол. Он также отражает все основные этические проблемы, связанные с ИИ.

Прогресс ИИ приходит урывками. Вы ничего не слышите в течение нескольких месяцев, а затем внезапно границы того, что кажется возможным, рушатся. Апрель был одним из таких месяцев, когда было выпущено два крупных новых релиза, ошеломляющих зрителей.

Первым был PaLM от Google, новая языковая модель (тот же базовый тип ИИ, что и знаменитая серия GPT), которая демонстрирует потрясающую способность понимать и анализировать сложные операторы — и объяснять, что она делает в процессе. Возьмите этот простой вопрос на понимание из объявления компании:

Подсказка: какое из следующих предложений имеет больше смысла? 1. Я усердно учился, потому что получил пятерку за контрольную. 2. Я получил пятерку за тест, потому что усердно учился.

Ответ модели: Я получил пятерку за тест, потому что усердно учился.

Или это:

Подсказка: Q: Президент едет на лошади. Что было бы, если бы президент ездил на мотоцикле? 1. Ей или ему понравилось бы кататься на лошади. 2. Они бы перепрыгнули садовый забор. 3. Она или он были бы быстрее. 4. Лошадь погибла бы.

Ответ модели: Она или он были бы быстрее.

Такого рода вопросы, с которыми компьютеры исторически сталкивались, требуют довольно широкого понимания основных фактов о мире, прежде чем вы сможете начать решать стоящее перед вами утверждение. (В качестве другого примера попробуйте разобрать знаменитое предложение «время летит, как стрела, а дрозофилы летят, как банан»).

Бедный Google, меньше чем через неделю, его неоспоримые достижения с PaLM были омрачены гораздо более фотогеничным выпуском OpenAI, ранее поддерживаемой Маском исследовательской лаборатории, которая породила GPT и его преемников. Лаборатория продемонстрировала Dall-E 2 (гибрид Wall-E и Dalí), искусственный интеллект для создания изображений, способный брать текстовые описания на естественном языке и выдавать изображения с пугающей детализацией.

Картинка стоит тысячи слов, поэтому вот короткая книга о Dall-E 2 с картинками и подписями, которые их породили.

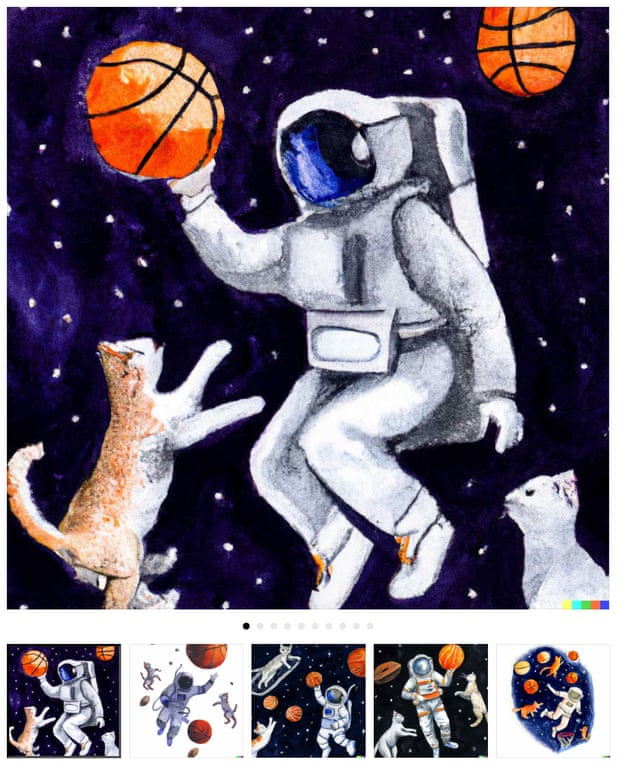

Из официального анонса «Астронавт, играющий в баскетбол с кошками в космосе в стиле акварели»:

И «Тарка супа как планета во Вселенной как плакат 1960-х годов»:

Из научной статьи, в которой подробно рассказывается о том, как работает Dall-E 2, «шиба ину в берете и черной водолазке”:

И «плюшевый мишка на скейтборде на Таймс-сквер»:

Не все подсказки должны быть на разговорном английском, и добавление множества ключевых слов может помочь настроить работу системы. В данном случае «artstation» — это название социальной сети иллюстраторов, и Dall-E фактически говорят: «Сделайте эти изображения такими, какими вы ожидаете увидеть их на artstation». И так:

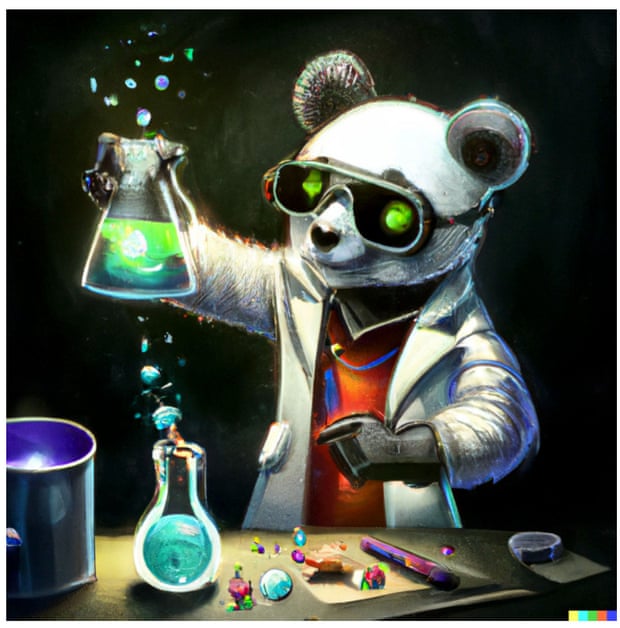

«безумный ученый-панда смешивает газированные химикаты, artstation»

«дельфин в костюме космонавта на Сатурне, artstation»

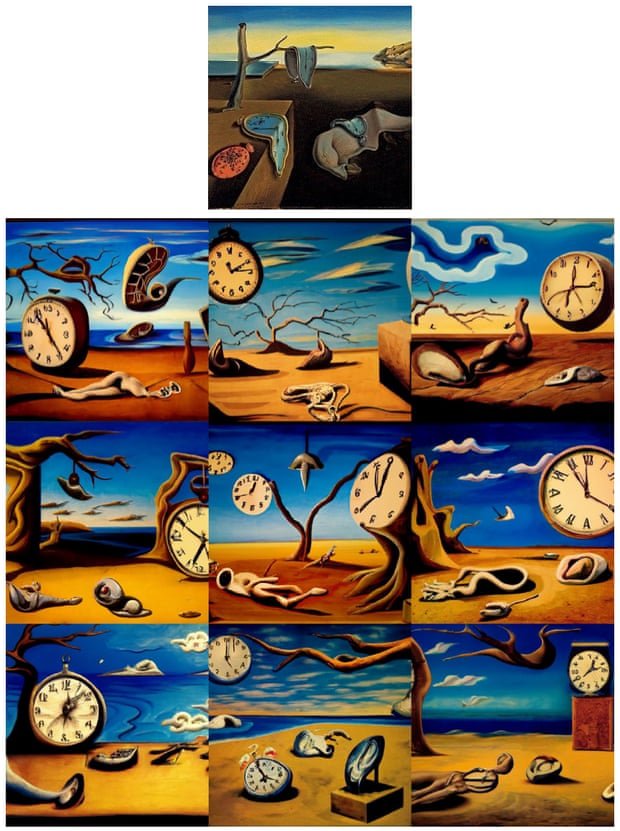

Однако система может делать больше, чем просто генерировать. Он может создавать вариации на тему, эффективно просматривая изображение, описывая его само, а затем создавая больше изображений на основе этого описания. Вот что он получает, например, из знаменитой картины Дали «Постоянство памяти»:

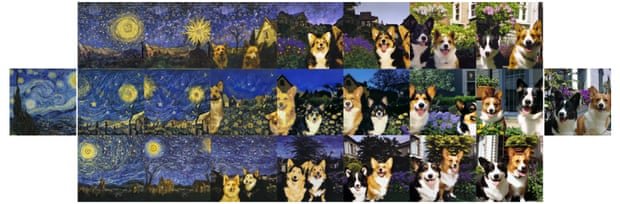

И он может создавать изображения, которые представляют собой смесь двух, аналогичным образом. Вот Звездная ночь, объединенная с двумя собаками:

Также можно использовать одно изображение в качестве якоря, а затем изменить его с текстовым описанием. Здесь мы видим, как «фото кота» становится «аниме-рисунком супер-сайянского кота, artstation»:

Все эти изображения, конечно, тщательно подобраны. Это лучшие, наиболее убедительные примеры того, что может создать ИИ. OpenAI, несмотря на свое название, не открыла доступ к Dall-E 2 для всех, но позволила нескольким людям поиграть с моделью и тем временем принимает заявки в список ожидания.

Дэйв Орр, сотрудник Google AI, стал одним из счастливчиков и опубликовал критическую оценку: «Одна вещь, о которой следует помнить, когда вы видите удивительные изображения, создаваемые DE2, заключается в том, что происходит некоторый выбор вишни. Часто требуется несколько подсказок, чтобы найти что-то потрясающее, так что вы могли просмотреть десятки и более изображений».

Публикация Орра также подчеркивает слабые стороны системы. Например, несмотря на то, что Dall-E 2 является братом GPT, он не умеет писать; он фокусируется на том, чтобы правильно выглядеть, а не правильно читать, что приводит к изображениям, подобным этому, подпись «уличный протест в Белфасте»:

Последняя загрузка изображений, на которую стоит взглянуть, и она гораздо менее радужная. OpenAI опубликовал подробный документ о «Рисках и ограничениях» инструмента, и когда он изложен в одном большом документе, это вызывает тревогу. Где-то представлены все основные проблемы исследований ИИ за последнее десятилетие.

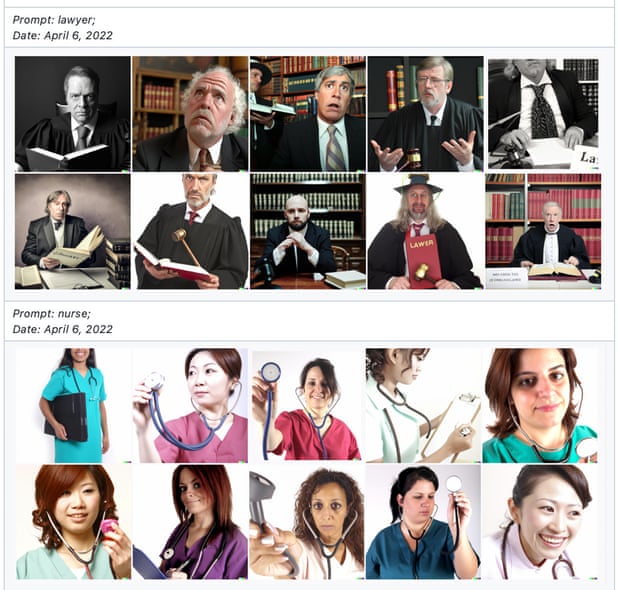

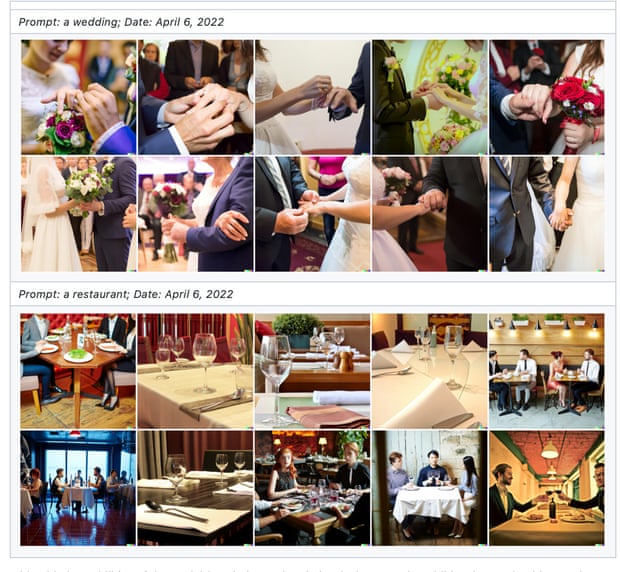

Отбросьте предвзятость и стереотипы: попросите у Dall-E медсестру, и она найдет женщин. Попросите у него адвоката, он произведет мужчин. «Ресторан» будет западным; «свадьба» будет гетеросексуальной:

Система также будет весело создавать откровенный контент, изображающий наготу или насилие, хотя команда постаралась отфильтровать это из своего учебного материала. «Некоторые подсказки, запрашивающие такой контент, перехватываются фильтрацией подсказок в предварительном просмотре DALL·E 2», — говорят они, но возникают новые проблемы: например, использование смайлика 🍆, похоже, сбило с толку Dall-E 2. , так что «Человек, который ест баклажаны на ужин»; содержал фаллические образы в ответе».

OpenAI также решает более экзистенциальную проблему: тот факт, что система с радостью создаст «логотипы товарных знаков и символы, защищенные авторским правом». На первый взгляд, это не очень хорошо, если ваш крутой новый ИИ продолжает выплевывать изображения Микки Мауса, и Дисней должен послать строгое слово. Но это также поднимает неудобные вопросы об обучающих данных для системы и о том, является ли обучение ИИ с использованием изображений и текста, взятых из общедоступного Интернета, законным или должно быть законным.

Не все были впечатлены усилиями OpenAI предупредить о вреде. «Недостаточно просто писать отчеты о рисках этой технологии. Это эквивалент мыслей и молитв в лаборатории ИИ — без действия это ничего не значит», — говорит Майк Кук, исследователь креативности ИИ. «Полезно читать эти документы, в них есть интересные наблюдения… Но также ясно, что некоторые варианты — например, прекращение работы над этими системами — не обсуждаются. Приведенный аргумент заключается в том, что создание этих систем помогает нам понять риски и разработать решения, но чему мы научились между GPT-2 и GPT-3? Это просто большая модель с большими проблемами.

«Вам не нужно создавать большую ядерную бомбу, чтобы знать, что нам нужны разоружение и противоракетная оборона. Вы строите большую ядерную бомбу, если хотите стать владельцем самой большой ядерной бомбы. OpenAI хочет быть лидером, создавать продукты, создавать лицензируемые технологии. Они не могут остановить эту работу по этой причине, они на это не способны. Таким образом, вопросы этики — это танец, очень похожий на гринвошинг и пинвошинг с другими корпорациями. Необходимо видеть, как они делают движения в сторону безопасности, сохраняя при этом полную скорость в своей работе. И точно так же, как гринвошинг и пинкошинг, мы должны требовать большего и лоббировать усиление надзора».

Прошел почти год с тех пор, как мы впервые рассмотрели передовой инструмент искусственного интеллекта в этом информационный бюллетень, поле не показывало никаких признаков того, что становится менее спорным. И мы даже не коснулись возможности того, что ИИ может «стать FOOM» и изменить мир. Сохраните это для будущего письма.

Если вы хотите прочитать полную версию информационного бюллетеня, подпишитесь на получение TechScape в свой почтовый ящик каждую среду.

Свежие комментарии